Ces dernières années, les principales failles de sécurité ont résulté de l’utilisation détournée d’informations oubliées ou « dormantes ».

Edward Snowden, par exemple, a simplement accédé à d’anciennes archives SharePoint de la NSA (National Security Agency) sans commettre de réel piratage.

Aujourd’hui, il ne s’agit plus de sécuriser la multitude de fichiers et contenus stockés par les entreprises derrière le pare-feu. La question est d’identifier les bons contenus à protéger et les bons contenus à supprimer en temps voulu.

Par William Bailhache, Vice-Président EMEA Sud d’Alfresco

Non structuré et non sécurisé

La faille de sécurité dont a été victime la NSA n’est pas un cas isolé. Les risques existent dans les secteurs tant publics que privés car l’enjeu sous-jacent est très courant. Les données stockées dans Dropbox, Fileshare, SharePoint et autres systèmes de gestion de contenu, dans le cloud ou derrière le pare-feu, sont non structurées.

Sans un cycle de vie clairement défini, elles ne peuvent pas être verrouillées, puis supprimées. Sans inventaire des données, les entreprises ne savent pas ce dont elles disposent et ne peuvent donc pas protéger leurs ressources.

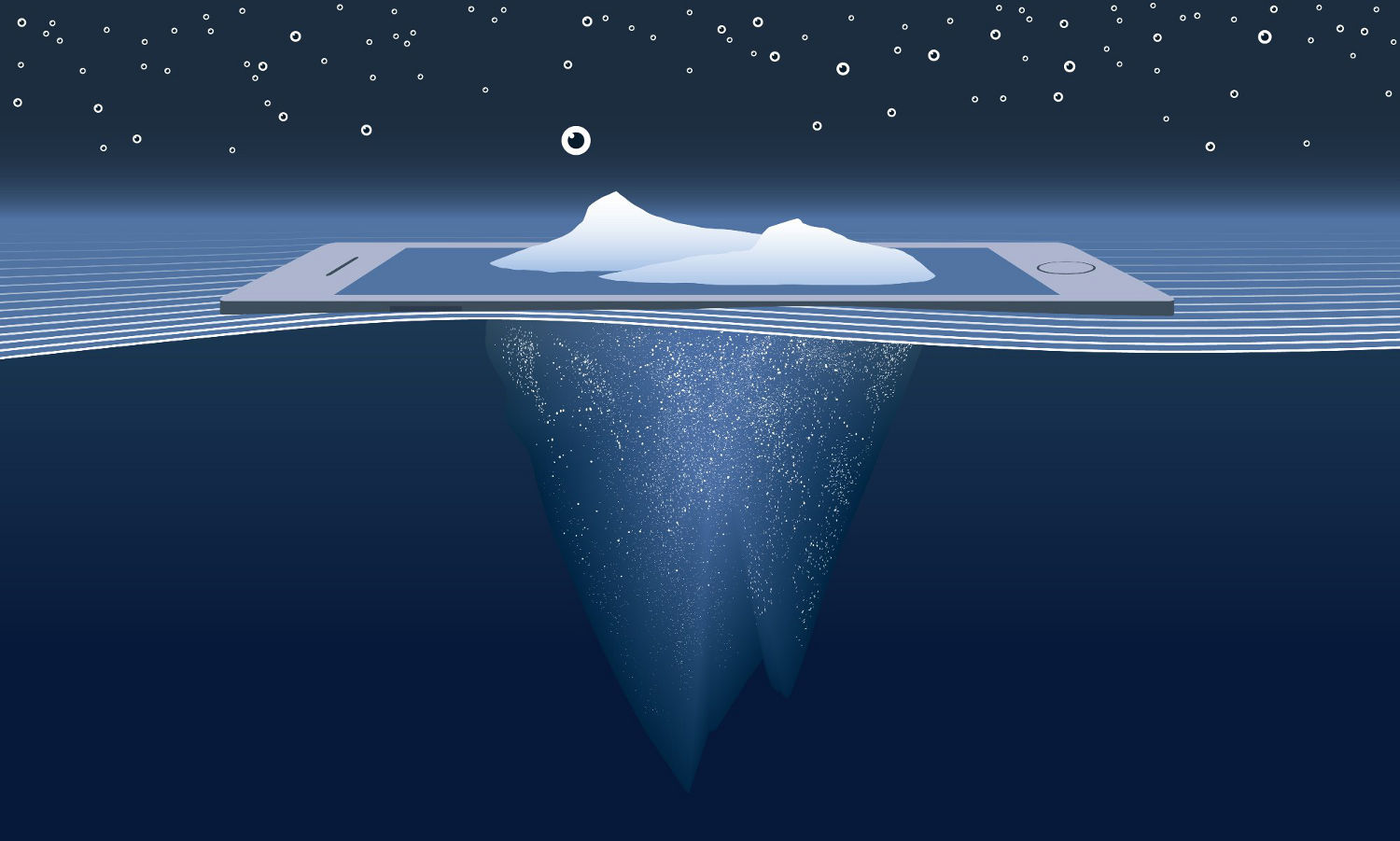

De plus, les prestataires de solutions cloud proposent des capacités de stockage illimitées ; si bien que de plus en plus de données sont créées et laissées à la dérive, sans contrôle, dans un océan infini d’informations.

Davantage de stockage, davantage de risque

Les entreprises et individus génèrent et amassent tellement de contenus qu’ils se retrouvent submergés par un véritable tsunami. Pour écrémer et rendre plus efficace le système, il faut gérer sa consommation et choisir un régime adapté pour tirer le meilleur parti de ce que l’on consomme. L’accumulation compulsive de données est l’un des principaux obstacles à la mise en place d’un cycle de vie sain et sécurisé dans l’entreprise.

Les grandes multinationales sont réticentes à supprimer les données anciennes au cas où elles serviraient par la suite ; elles ont du mal à renoncer à des contenus qui aujourd’hui n’ont pourtant pas de réelle valeur pour l’activité.

Curieusement, la valeur de ces données conservées en masse par ces multinationales florissantes est négligeable. Stockées sans être utilisées, elles compromettent la sécurité de par leur existence-même alors qu’elles ne servent à rien. Le contenu dormant crée une contrainte de responsabilité.

« Connaissez-vous le volume d’informations qui circule dans votre entreprise et la proportion qui génère réellement de la valeur ? »

Je pose souvent cette question aux dirigeants avec lesquels je travaille et, la plupart du temps, ils sont incapables d’y répondre. Contrairement aux données en mouvement, qui génèrent des revenus, les données dormantes génèrent un risque.

Outre la question des revenus, les conséquences légales liées à la masse d’informations sensibles non structurées, comme les dossiers médicaux, qui pourraient être compromises sont encore plus préoccupantes.

Souvent, il suffit à un « hacker » de connaître le mot de passe du portail de stockage pour accéder à l’ensemble des données utilisateur. Même les plus grandes entreprises ont du mal à garantir la sécurité des espaces de stockage, à stocker correctement ces données, mais aussi à fournir à leurs collaborateurs un système simple pour les utiliser et les conserver en toute sécurité.

Plus d’autonomie pour les travailleurs du savoir

On entend par travailleur du savoir toute personne qui gagne sa vie en développant ou utilisant du savoir. Cette définition étant très large, on comprend que cette force de travail couvre un grand nombre de secteurs d’activité.

Les travailleurs du savoir doivent constamment naviguer dans des volumes colossaux d’informations pour y trouver rapidement la bonne version du bon contenu. Il faut leur permettre d’accéder en temps voulu aux informations dont ils ont besoin. Pour ce faire, les entreprises doivent créer un flux numérique, un inventaire des processus métiers, qui donne facilement accès aux ressources utiles.

Prenons l’exemple du personnel hospitalier. Comme le prévoit le CMS (Centers for Medicare and Medicaid Services), les dossiers médicaux des patients doivent être conservés pendant sept ans au minimum.

Si les dossiers sont intégrés à un flux numérique clairement défini avec un cycle de vie précis, les informations des patients sont facilement accessibles au personnel hospitalier dès qu’ils se présentent à l’hôpital.

Dans les systèmes sans flux numérique, la conservation et la gestion sécurisée des données reposent essentiellement sur l’utilisateur. C’est pourquoi les entreprises ont déjà dépensé 28 Mrd $ dans ces technologies et seuls 50 % des projets ECM (Enterprise Content Management) de grande envergure ont été adoptés avec succès.

Les millénials, fauteurs de troubles

La technologie évolue chaque jour en vue d’améliorer ces processus. Il est vrai qu’un travail aussi ennuyeux et fastidieux est plus précis s’il est effectué avec les méthodes d’apprentissage machine et l’intelligence artificielle. D’ici quelques années, les entreprises n’auront de toute façon plus le choix. La génération du millénaire refuse de continuer à crouler sous les tâches et rejette de plus en plus les anciennes technologies. Elle veut pouvoir accéder à la version la plus récente des contenus nécessaires à son travail, et ce, aussi efficacement que possible.

Les grandes institutions comme les banques et les compagnies d’assurance qui poussent leurs informaticiens à apprendre à coder et protéger les informations constatent déjà des bénéfices en termes de croissance et d’efficacité. Elles se modernisent et renoncent peu à peu aux anciens processus. Les millénials bouleversent les anciens modes de fonctionnement, et le résultat est payant pour ceux qui l’acceptent.

Il est difficile de rompre avec les anciens systèmes mainframe et les agences gouvernementales en particulier veulent moderniser leurs infrastructures ; la NASA elle-même a sauté le pas il y a cinq ou six ans. Traditionnellement, le gouvernement fédéral américain a toujours été plus lent à adopter les technologies modernes. Mais l’impulsion est donnée. Pour preuve le budget alloué au Département de la Défense américain (DoD) pour la lutte contre les cyberattaques, essentiellement à la suite de failles comme celle dont l’Office of Personnel Management (OPM) a été la cible.

L’avenir

À mesure que de plus en plus d’administrations et d’entreprises se modernisent, maîtrisent leurs données et sécurisent les cycles de vie, les composants logiciels des systèmes gagnent en efficacité. À terme, la technologie supplantera toute intervention humaine, remplacera l’utilisateur final et supprimera le « facteur humain » et les erreurs potentielles qui en découlent en termes de sécurité. Que les erreurs soient volontaires ou fortuites, les utilisateurs sont des êtres humains et, contrairement à la technologie, ils ne sont pas infaillibles.

De plus, les menaces évoluent elles aussi. Les cyberattaques ont toujours visé de gros poissons, comme le DoD et d’autres agences avec les moyens nécessaires pour riposter et se défendre. Toutefois, le terrorisme d’état évolue et de plus en plus de hackers se tournent vers des cibles plus vulnérables comme des hôpitaux ou des institutions financières de moindre envergure.

La cyberattaque de 2017 contre le NHS est révélatrice de ce que réserve l’avenir. La technologie utilisée pour contrer les hackers doit anticiper et répondre aux besoins des entreprises et agences gouvernementales : mieux vaut prévenir en protégeant ses données que guérir.

C’est la capacité d’une solution à identifier les données dont la valeur justifie l’intégration à un cycle de vie (où elles sont gérées, utilisées et à terme supprimées) et ce qui doit être verrouillé, conservé à l’écart et rester intouchable qui fera la différence. La clé d’une solution performante, d’un flux numérique efficace et d’une protection sécurisée est l’attention égale portée au processus et aux ressources. Elle permet un contrôle efficace et un processus simple pour bien protéger les données et l’automatisation complète du cycle de vie, de la capture initiale jusqu’à la suppression finale.

Parmi les nombreuses menaces qui visent les entreprises et agences gouvernementales, la masse de contenus dormants est la plus négligée. Pour bien prendre en compte cette vulnérabilité et prévenir des failles désastreuses en protégeant les contenus, il faut gérer et protéger les données oubliées, silencieuses et « sans importance » avec la plus grande vigilance.