Comment les Français perçoivent et comprennent le Big Data ? A l’occasion du salon Big Data Paris, Harris Interactive vient de publier les résultats d’une enquête qui permet de dresser un état des lieux de la relation (ambiguë) qu’entretiennent les Français avec ce sujet…

Dans le cadre de l’édition 2016 du salon annuel Big Data Paris, qui se tient les 7 et 8 mars, Quantmetry a demandé à Harris Interactive de réaliser une étude d’opinion permettant de mieux comprendre quel rapport les Français entretiennent avec le terme « Big Data », avec la réalité d’une exploitation des données, et quelles attentes ils peuvent formuler dans ce contexte en mutation.

Une notion encore floue pour la majorité des Français

Les Français expriment une certaine distance, voire parfois de la méfiance, vis-à-vis du « Big Data ». Néanmoins, ils le perçoivent comme un sujet important pour aujourd’hui comme pour demain, une opinion plus positive notamment portée par les Français ayant déjà pu se familiariser avec le terme « Big Data » et ses utilisations.

« Big Data ». S’il n’existe pas de consensus sur la définition de ce terme parmi les spécialistes, quelles représentations les Français peuvent-ils en avoir ? Interrogés sur les évocations qui leurs viennent spontanément à l’esprit lorsqu’ils pensent au « Big Data », seule une minorité de Français s’estime capable de répondre à cette question et 59% d’entre eux indiquent ne pas savoir ce que signifie ce terme.

Les Français s’estimant en capacité de s’exprimer identifient correctement l’univers du « Big Data » (« informatique », « Internet », « Cloud », « stockage »). Par ailleurs, dès cette première question, apparaissent les doutes qu’une partie d’entre eux peut exprimer quant à l’utilisation supposée de ces données (« espionnage », « Big Brother », « marketing »).

Un manque d’informations…

Quelle que soit leur connaissance du terme et des réalités qu’il recouvre, les Français ont été appelés à s’exprimer sur la fréquence à laquelle ils ont entendu parler de « Big Data » au cours des 6 derniers mois. Plus de 6 sur 10 (61%) indiquent qu’ils n’ont pas même une fois entendu ce terme au cours du dernier semestre.

Par ailleurs, 19% des Français affirment en avoir entendu parler moins d’une fois par mois, et seulement 17% plus souvent. Notons que si seul un tiers (36%) de l’ensemble Français affirme avoir entendu parler de « Big Data » au cours des 6 derniers mois, ils sont un peu plus nombreux parmi les hommes (47%), les PCS+ (54%), les Franciliens (44%) et les personnes ayant obtenu un diplôme supérieur à Bac +2 (52%).

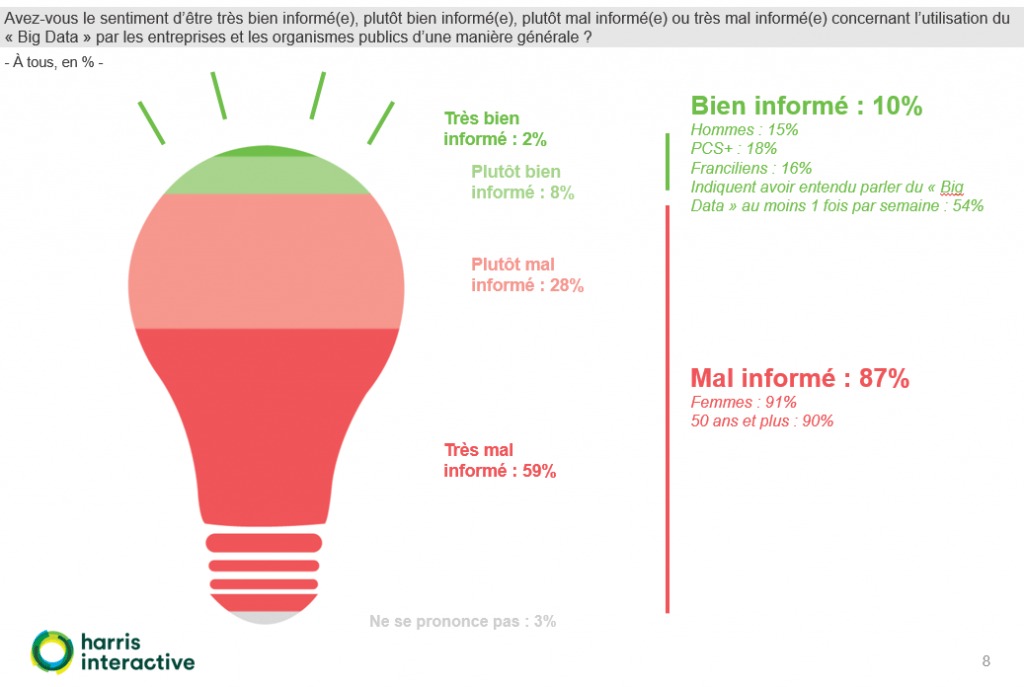

Conscients de leurs limites sur ce sujet, les Français se définissent très majoritairement (87%) comme mal informés concernant l’utilisation du « Big Data » par les entreprises et les organismes publics d’une manière générale (59% se disant même « très mal informés »).

Ce taux atteint même 91% parmi les femmes et 90% parmi les 50 ans et plus. A l’inverse, 1 Français sur 10 estime qu’il est bien informé sur ce sujet (10%, 2% « très bien informé »), ici encore, particulièrement, bien que de façon minoritaire, parmi les hommes (15%), les PCS+ (18%) et les Franciliens (16%).

Notons enfin que parmi les personnes ayant entendu parler du « Big Data » au moins 1 fois par semaine au cours des 6 derniers mois, soit les Français les plus familiers avec ce domaine, seuls 54% s’estiment bien informés.

Preuve de cette information parcellaire, les Français se montrent partagés sur l’utilisation du « Big Data » par les différents acteurs publics et privés testés dans l’étude.

Ainsi peu de différences sont observées entre Netflix et EDF, 2 sociétés dont l’activité utilise du « Big Data » selon 1 Français sur 2 (50%), et Pôle Emploi, dernier de la liste, pour qui cette opinion est partagée par 42% des Français.

Notons que les personnes ayant été en mesure d’identifier le « Big Data », perçoivent davantage le recours des acteurs à cet outil mais sans qu’une hiérarchie claire apparaisse ici également (de 59% pour Pôle Emploi à 73% pour Netflix).

Enfin, l’indécision des Français ne doit pas laisser croire à une opinion peu structurée : au contraire, elle s’organise autour des deux positionnements monolithiques : un tiers (35%) des Français estime qu’aucun des acteurs testés n’a recours au « Big Data » alors qu’un autre tiers (31%) adopte la position strictement opposée en affirmant que tous les acteurs testés utilisent cette technologie.

… qui génère une forte méfiance

Dans ce contexte de connaissance parcellaire du « Big Data », les Français ont été invités à s’exprimer sur leurs pratiques sur Internet. Plus exactement, ils ont été interrogés sur l’évolution de leurs pratiques en termes de communication de leurs données personnelles.

Si 53% d’entre eux affirment qu’ils n’y a pas eu de changement dans ce domaine, plus d’1 sur 4 (28%) indique qu’il accepte moins facilement de communiquer ce type de données aujourd’hui qu’il y a quelques années (et même 32% des 65 ans et plus), contre 17% des Français affirmant qu’ils acceptent plus facilement de les communiquer (et même 24% parmi les populations les plus technophiles).

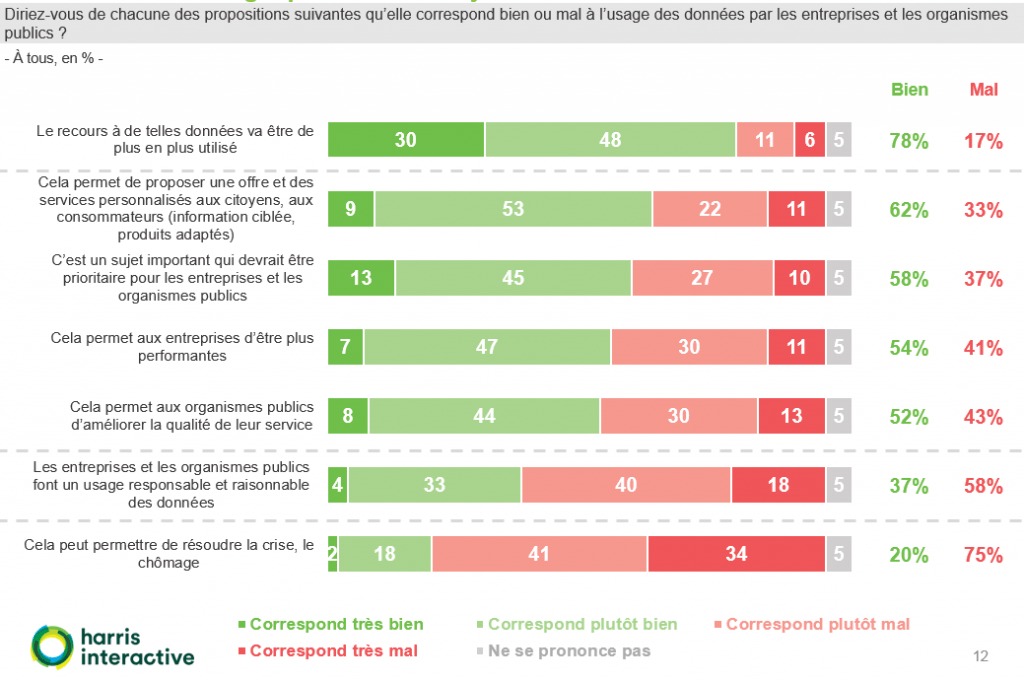

Cette évolution déclarée du rapport aux données personnelles peut être en partie expliquée par la méfiance de près de 6 Français sur 10 quant à l’usage « responsable et raisonnable » qu’en feraient les entreprises. Ces mêmes doutes accompagnent la capacité de cette technologie à résoudre la crise et le chômage (75%).

A l’inverse, une majorité de Français estime que le recours aux données va être de plus en plus utilisé (78%), qu’il permettra de proposer une offre et des services personnalisés (62%), et qu’il s’agit d’un sujet qui devrait être prioritaire pour les entreprises et les organismes publics (58%) car leur permettant de s’améliorer (respectivement 54% et 52%).

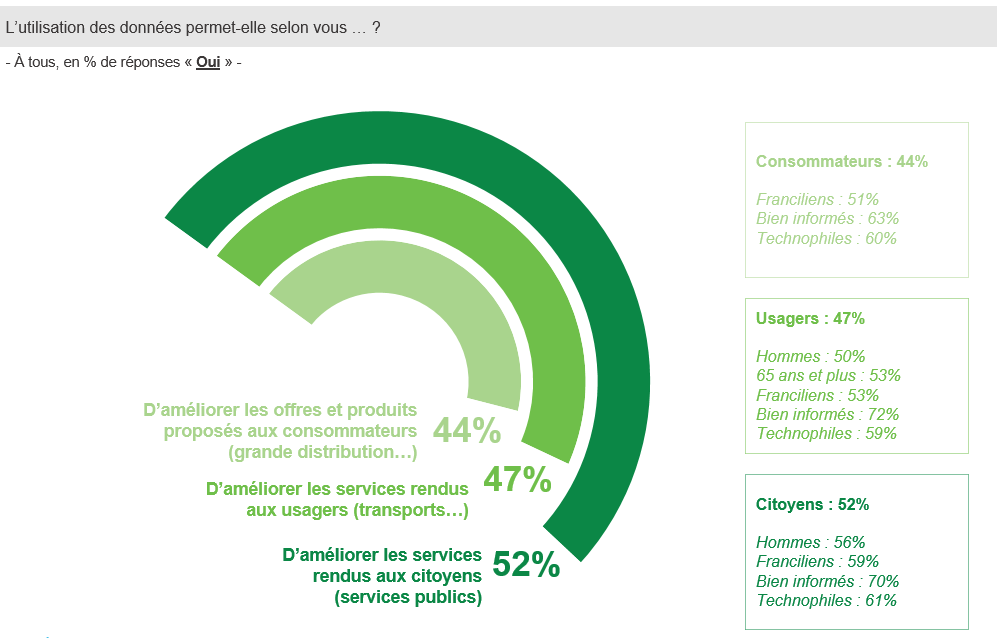

Notons que plus les Français se sentent au fait de ces sujets, et plus ils anticipent positivement les différentes dimensions testées ici. Plus largement, le recours au données est vu comme une amélioration des services selon une moitié de Français, avec néanmoins des différences lorsque l’on considère les consommateurs (44%), les usagers (47%) ou les citoyens (52%). Ici encore, les personnes bien informées sur le sujet et les plus technophiles sont davantage enclins à percevoir les effets positifs des données.

Dans un contexte en perpétuelle mutation, en quels acteurs les Français déclarent-ils avoir confiance en ce qui concerne la gestion des données ?

Après les professionnels de santé (67%), les acteurs publics sont identifiés comme ceux captant majoritairement la confiance des Français: 65% de confiance pour la CNIL, 62% pour les organismes publics (sécurité sociale, etc.)…

Si les acteurs privés traditionnels se démarquent des réseaux sociaux et grand acteurs du web, objets d’une méfiance toute particulière (18% de confiance pour 78% de non confiance), ils bénéficient aujourd’hui d’une confiance en matière de gestion des données qui apparaît limitée (entre un quart et la moitié des Français seulement indiquent leur faire confiance aujourd’hui).

La même hiérarchie entre les acteurs se dessine lorsque l’on interroge les Français sur les domaines dans lesquels ils sont favorables à une utilisation plus importantes des données : professionnels de santé et acteurs publics arrivent en tête, mais avec le soutien d’à peine la moitié des Français.

Que ce soit pour la confiance ou les domaines dans lesquels ils pourraient considérer une utilisation plus importante des données, les Français se sentant les mieux informés sur le « Big Data » se montrent bien plus positifs que ceux qui s’en sentent distants.

Cette réticence face à une utilisation croissante des données par les différents acteurs va de pair avec l’importante proportion de Français (61%) qui ne souhaite ni recevoir des publicités ciblées par rapport à leur historique de recherches, ni offrir aux entreprises ou aux pouvoirs publics la possibilité de les localiser, ni renoncer à la possibilité d’effacer leurs publications partagées, ni laisser les entreprises vendre ou louer leurs données.

Notons néanmoins que cette opinion est principalement partagée par les personnes se sentant les moins bien informées sur le « Big Data », et qu’à l’inverse près de 4 Français sur 10 seraient prêt à accepter une de ces propositions si on lui garantissait l’accès à de meilleurs offres, à de meilleurs prix ou à de meilleurs services.

Au final, dans le contexte actuel d’une information parcellaire, souvent corrélée à une attitude de méfiance, voire de rejet, vis-à-vis du « Big Data », mais bien moins importante parmi les catégories de la population qui ont commencé à s’y familiariser, seuls 15% des Français perçoivent le « Big Data » comme une source d’opportunité pour les consommateurs dont les besoins seront mieux connus, alors que 81% estiment qu’ils sera à l’origine de risques de « fichage » de ces mêmes consommateurs.

Méthodologie

Enquête réalisée en ligne du 29 février au 2 mars 2016. Échantillon de 1 487 personnes, représentatif des Français âgés de 18 ans et plus. Méthode des quotas et redressement appliqués aux variables suivantes : sexe, âge, catégorie socioprofessionnelle et région de l’interviewé(e).

Source : Harris Interactive