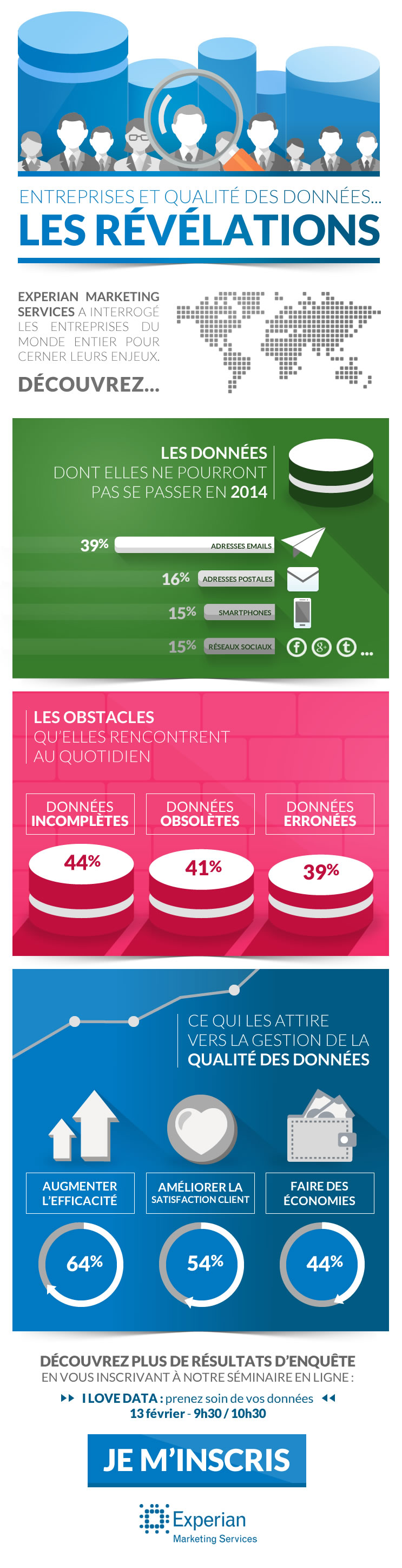

Selon la dernière étude réalisée par Experian Marketing Services, les entreprises Françaises estiment que 19% de leurs données sont erronées.

Cette mauvaise qualité des datas a un impact négatif sur les budgets, les actions marketing et surtout, sur la satisfaction client.

Experian Marketing Services, vient de publier un nouveau livre blanc « Qualité des données en 2014 : tendances et best practices pour réussir sa stratégie ».

L’enquête montre à quel point les données sont devenues un composant crucial de l’interaction client et de la prise de décision, tout en demeurant fortement pénalisantes pour les organisations en cas d’inexactitude.

En moyenne, les entreprises Françaises estiment que 19% de leurs données sont erronées, avec un impact reconnu sur les stratégies business intelligence, marketing et engagement client. Un tel niveau d’inexactitude est avant tout dû aux erreurs humaines, qui surviennent par manque d’une stratégie de gestion de la qualité des données qui soit cohérente et centralisée. 66% des entreprises n’ont en effet aucune approche centralisée en place, ce qui les empêche d’analyser, d’améliorer et de contrôler les problèmes de données, en divisant les ressources et l’information en silos.

« Le volume croissant de données signifie que davantage d’entreprises cherchent à prendre des décisions plus éclairées à partir des informations qu’elles détiennent » déclare Stéphane Baranzelli, Directeur Général France, Experian Marketing Services. « La qualité des données est le socle de tout effort orienté data, mais son niveau est assez médiocre en général. Les entreprises doivent centraliser leur approche de la gestion des données pour s’assurer que les informations soient correctement collectées et utilisées ensuite de manière efficace dans l’environnement cross-canal actuel » ajoute-t-il.

L’étude révèle que les entreprises cherchent à mieux coordonner leur exécution à travers les différents canaux : 87% des organisations déclarent s’orienter vers le marketing cross-canal. Cependant, la majorité d’entre elles font face à des challenges de taille liés à cette évolution, principalement dus à l’inexactitude des informations ou au manque d’information client. En effet, 94% des organisations sont contraintes d’enrichir leurs données contacts.

Les autres chiffres à retenir de cette étude sous forme d’infographie: