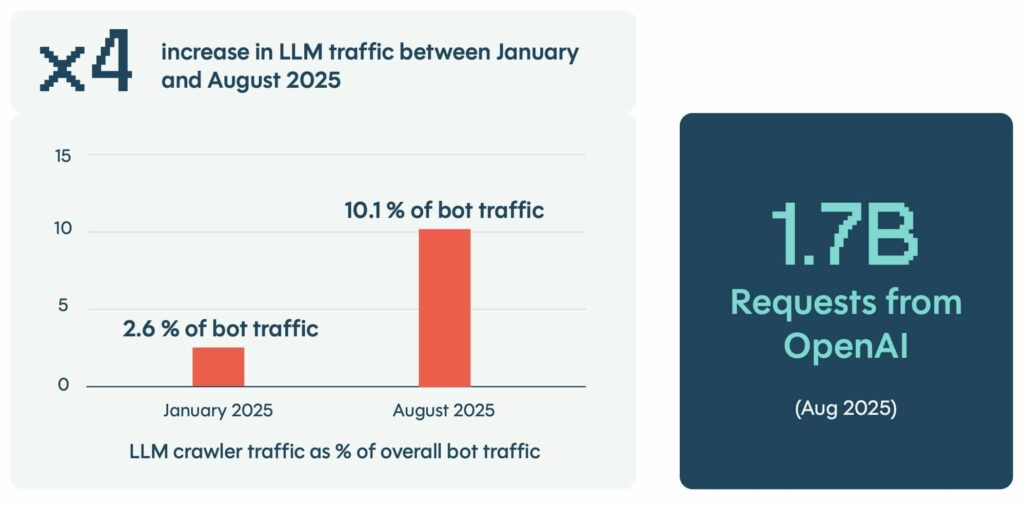

Selon le Global Bot Security Report 2025 de DataDome, le trafic généré par les robots d’indexation et les agents IA a quadruplé en quelques mois.

En août, il représentait plus de 10 % des requêtes en ligne, avec près de 1,7 milliard de requêtes détectées rien que pour OpenAI.

Le trafic généré par l’IA n’est plus anecdotique, il devient une composante à prendre sérieusement en compte…

Des bots indétectables par les défenses classiques

Ces robots d’indexation extraient des quantités massives de contenu web, généralement sans consentement ni surveillance, épuisent les ressources du serveur et exposent les données propriétaires.

Les entreprises tentent de résister, mais sans succès : 88,9 % des domaines interdisent GPTBot dans leurs fichiers robots.txt, une mesure qui offre peu de protection réelle.

Les robots d’indexation et les navigateurs basés sur l’IA ignorent ces directives, rendant ces stratégies de blocage plutôt obsolètes.

Ces nouveaux agents IA sont capables d’imiter le comportement humain, de générer des navigateurs synthétiques à la volée, de contourner les CAPTCHA et de s’adapter en temps réel.

Autrement dit, ils brouillent les repères et rendent obsolètes les défenses classiques. La frontière entre un internaute légitime et une requête pilotée par l’IA devient de plus en plus floue.

Des risques accrus pour les entreprises

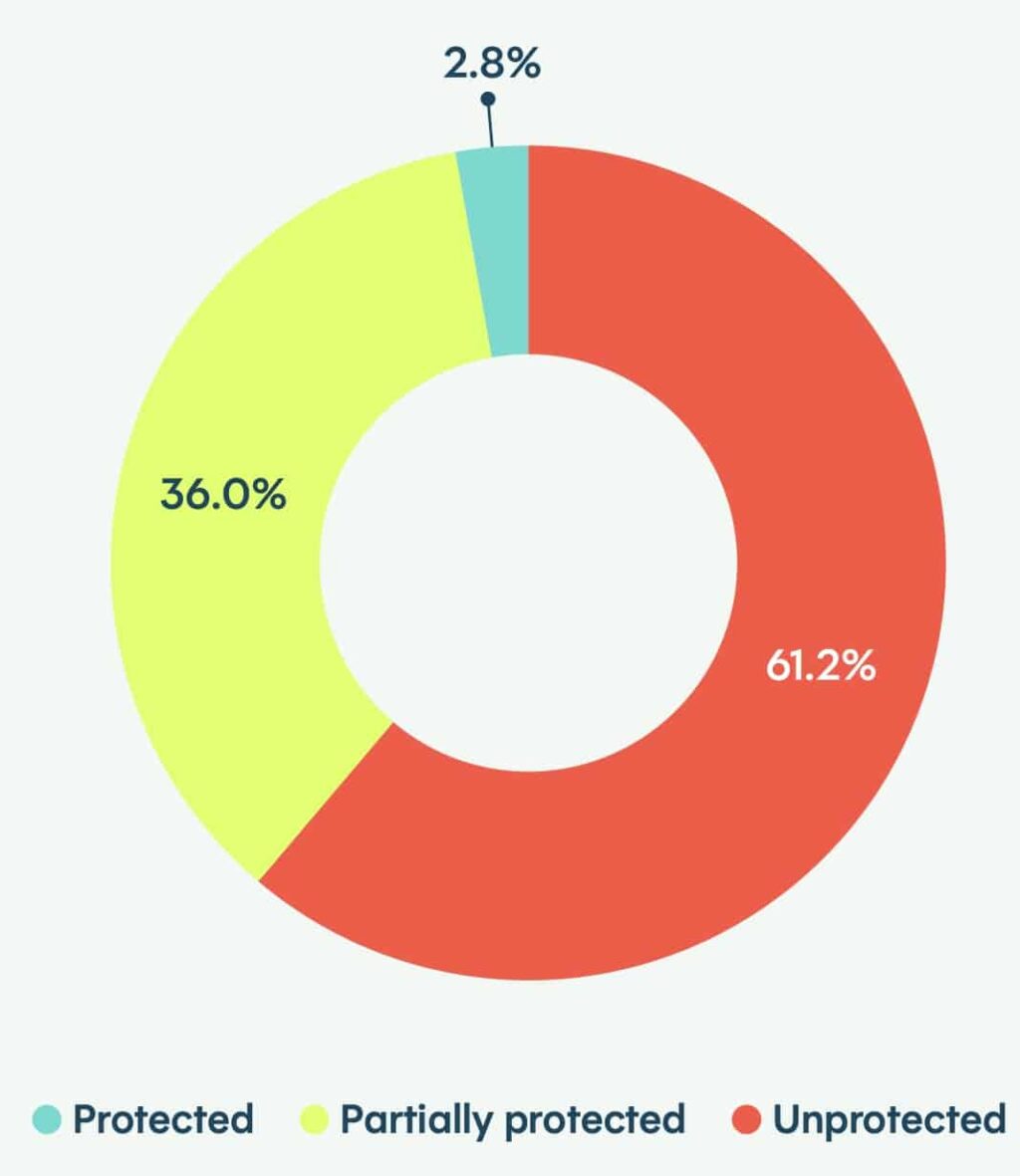

Le rapport souligne une défaillance globale des protections : seuls 2,8 % des sites web analysés étaient totalement protégés en 2025, contre 8,4 % l’année précédente.

Même les grandes plateformes ne font pas mieux : parmi celles dépassant les 30 millions de visites mensuelles, seulement 2 % disposent d’une sécurité efficace.

Cette faiblesse permet aux bots les plus avancés de franchir sans difficulté les étapes critiques d’un site : formulaires, pages de connexion, voire flux de paiement.

À la clé, un risque accru de fraude, de vol de comptes et de saturation des infrastructures.

La France n’échappe pas aux bots

L’Hexagone suit la tendance mondiale. DataDome a bloqué plus de 400 milliards d’attaques de bots en un an, en hausse de 14 %.

Certains secteurs restent particulièrement exposés : la santé et le jeu vidéo n’affichent aucune protection totale. À l’inverse, le bâtiment tire son épingle du jeu avec 23 % de sites protégés.

Un double défi pour l’avenir

Le rapport souligne une ambiguïté majeure : tout trafic IA n’est pas malveillant. Certaines requêtes ouvrent la voie à de nouveaux usages et à l’innovation.

Mais faute de pouvoir en distinguer l’intention, les entreprises risquent soit de bloquer l’innovation, soit de s’exposer à la fraude.

Pour Jérôme Segura, vice-président de la recherche chez DataDome, une certitude s’impose :

« Les entreprises doivent apprendre à gérer ce double défi : se protéger des menaces sophistiquées tout en exploitant les opportunités offertes par le trafic généré par l’IA. La sécurité doit impérativement évoluer à la vitesse de l’IA. »

Ce rapport confirme que l’IA est en train de transformer durablement la structure d’Internet.

Les sites web ne se contentent plus d’opposer humains et robots : ils sont confrontés à un spectre d’activités d’IA mêlant automatisation et intervention humaine, rendant les outils traditionnels de moins en moins efficaces et remettant en cause les stratégies de défenses actuelles…